Cos’è BerriAI-litellm e a cosa serve?

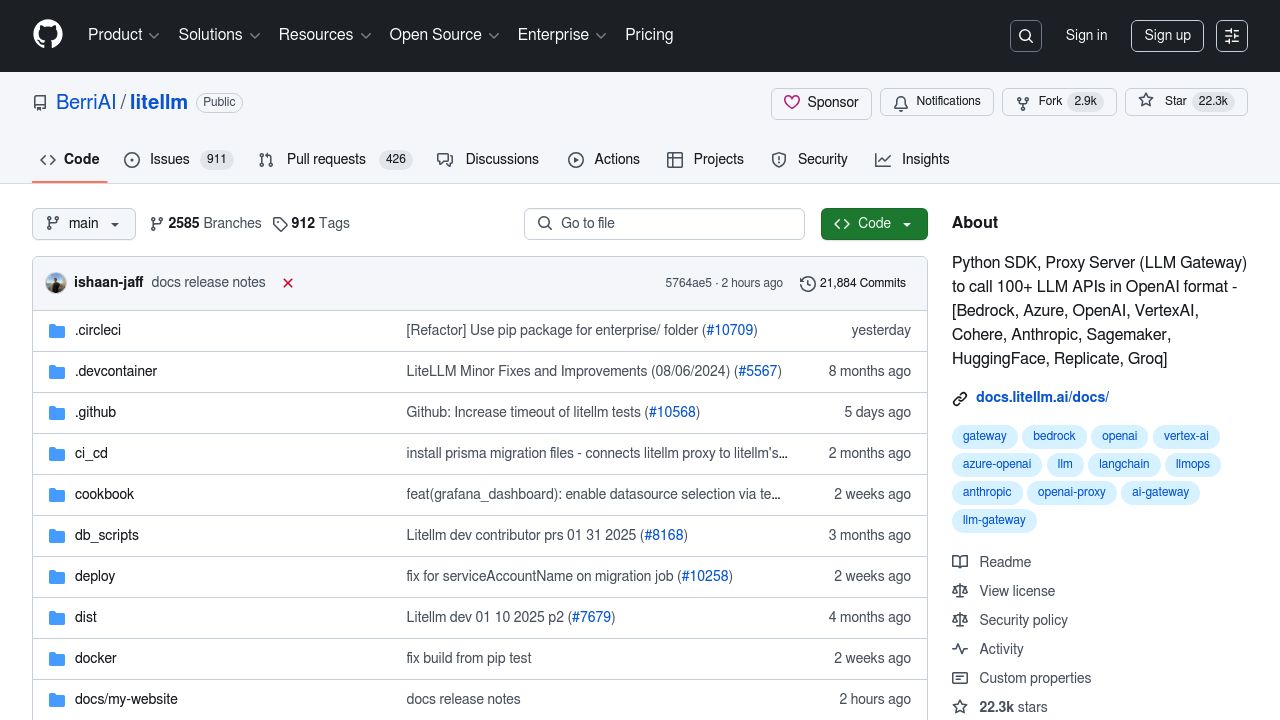

BerriAI-litellm è uno strumento innovativo che rivoluziona l’interazione con i large language models (LLM) offrendo un SDK Python e un Proxy Server progettati per integrarsi senza problemi con oltre 100 API LLM nel formato OpenAI. Questo tool è pensato principalmente per sviluppatori e aziende che necessitano di semplificare l’accesso e la gestione di molteplici API di modelli linguistici, come Bedrock, Azure, OpenAI e VertexAI.

La caratteristica distintiva di BerriAI-litellm è la sua capacità di ridurre le complessità legate alla gestione e alla traduzione delle chiamate tra diverse piattaforme di intelligenza artificiale, offrendo un’interfaccia uniforme per lavorare con i LLM più diffusi. Grazie a questa soluzione, è possibile ottimizzare i flussi di lavoro e migliorare l’efficienza nello sviluppo di progetti basati su intelligenza artificiale.

Campi di applicazione e esempi di utilizzo

La versatilità di BerriAI-litellm lo rende adatto a diversi ambiti applicativi, soprattutto in contesti dove la scalabilità e la gestione efficiente dei modelli linguistici sono fondamentali. Gli utilizzatori principali di questo strumento sono:

- Sviluppatori software che necessitano di integrare facilmente più API LLM nelle loro applicazioni;

- Ricercatori nel campo dell’intelligenza artificiale che lavorano su esperimenti e test con diversi modelli;

- Aziende tecnologiche che vogliono ottimizzare l’uso di più fornitori di modelli AI in modo centralizzato;

- Data scientist che gestiscono esperimenti e analisi tramite modelli linguistici diversi.

Tra le funzionalità più apprezzate troviamo:

- Supporto per oltre 100 API LLM con formati di output uniformi;

- Logica di retry e fallback per garantire affidabilità;

- Limitazioni di budget e rate limiting per il controllo dei costi;

- Tracciamento dei costi, bilanciamento del carico e distribuzione delle richieste tra fornitori diversi.

La versione gratuita consente di provare molte delle funzionalità principali senza alcun costo, rendendo BerriAI-litellm un’opzione attraente per chi vuole iniziare con la gestione avanzata di modelli linguistici multipli.

Conclusioni

In sintesi, BerriAI-litellm si configura come uno strumento completo e professionale per la gestione e l’integrazione di molteplici large language models. La sua capacità di unificare chiamate API diverse in un unico formato facilita enormemente gli sviluppatori e le imprese impegnate in progetti AI complessi.

Con un punteggio di 4,5 su 5 in termini di precisione, affidabilità, usabilità, funzionalità, velocità, flessibilità, sicurezza, supporto, costo e integrazione, questo tool si posiziona come una soluzione ideale per chi cerca un sistema scalabile e performante per gestire modelli linguistici in ambienti professionali.

La possibilità di monitorare costi e distribuire carichi di lavoro tra vari provider, unita alla semplicità d’uso offerta dall’SDK Python e dal Proxy Server, rende BerriAI-litellm una risorsa preziosa per chi sviluppa e ricerca nel campo dell’intelligenza artificiale.